逻辑回归

Logistic 回归为概率型非线性回归模型,是研究分类观察结果(Y)与一些影响因素(X)之间关系的一种多变量分析方法。

在实际工作中,经常需要研究某分类变量与一组自变量之间的关系。此时,若对分类变量直接拟合回归模型,则实质上拟合的是因变量某个类别的发生概率,参照线性回归模型的架构,有如下形式:

\[ \hat { P } = \alpha + \beta _ { 1 } x _ { 1 } + \ldots + \beta _ { m } x _ { m } \]

其中,\(\hat { P }\)是因变量发生概率。该模型可以描述当各个自变量变化时,因变量的发生概率会怎样变化,因而可满足分析的基本需要。

但是单纯的线性回归无法将因变量的值限制在0-1的范围内。因此,1970年,Cox引入了用于人口学领域的logit变换,通过对因变量进行转换解决了问题。Logit 变换,就是发生比的对数,即:

\[ Ln ( \Omega ) = L n ( odds ) = Ln \left( \frac { P } { 1 - P } \right) \]

通过转换后,logit P的取值范围扩展为以0为对称点的整个实数区,从而使得在任何自变量取值下,对P值的预测均有实际意义。

大量实践证明,logit P往往和自变量呈线性关系。换言之,概率值P与自变量之间的非线性关系符合logit 函数关系。从而可以通过该变换将曲线直线化。因此,只需要以 Logit P为因变量,建立包含n个自变量的Logistic回归模型即可:

\[ \operatorname { logit } \mathrm { P } = \alpha + \beta _ { 1 } x _ { 1 } + \ldots + \beta _ { n } x _ { n } \]

由上述模型可以逆推事件发生的概率P:

\[ p = \frac { e ^ { \alpha + \beta _ { 1 } x _ { 1 } + \ldots + \beta _ { n } x _ { n } } } { 1 + e ^ { \alpha + \beta _ { 1 } x _ { 1 } + \ldots + \beta _ { n } x _ { n } } } \]

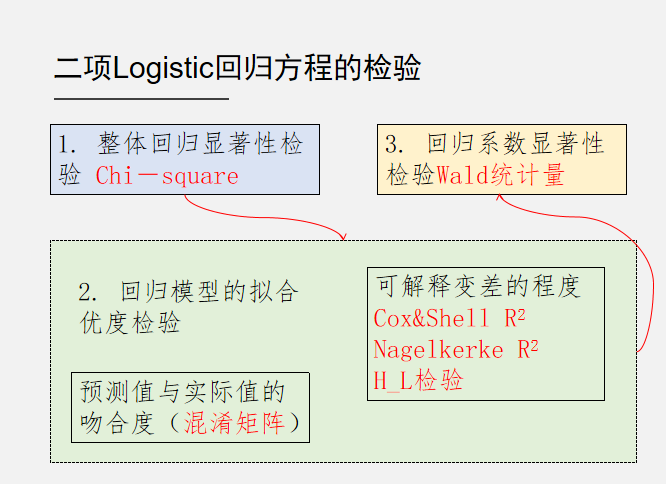

二项Logistic回归方程的检验

回归方程的显著性检验

检验自变量全体与Logit P的线性关系是否显著。其原假设为各回归系数同时为0,自变量全体与Logit P的线性关系不显著。使用的检验统计量为似然比卡方(Chi-square)。

回归系数的显著性检验

逐个检验方程中各自变量是否与Logit P 有显著的线性关系,对因变量的Logit P是否有重要贡献。原假设为当前自变量的系数为0。其使用Wald统计量进行检验,该统计量符合卡方分布。

回归方程的拟合优度检验

与一般线性回归不同,逻辑回归中拟合优度的检验可以从以下两个方面进行考察:

- 回归方程能够解释因变量变差的程度。类似于一般线性回归分析。

- 回归方程的预测值与实际值之间吻合的程度。即需要检验方程的总体错判率;错判率低表明拟合优度高。

主要指标有三个:

- Cox & Snell \(R^2\)统计量,类似于一般线性回归方程的R2指标。

- Nagelkerke \(R^2\),修正了的Cox & Snell R2,范围在(0,1)之间。接近1,拟合效果越好;接近0,拟合效果差。

- Hosmer-Lemeshow检验:Hosmer-Lemeshow统计量越小,拟合效果越好,反之拟合效果差。检验若p<显著度水平,则拟合效果差,拒绝H0;否则接受H0,认为预测与实际情况吻合度较好。

除此之外,也可以使用混淆矩阵来判断模型的拟合效果。

上述检验可以汇总如下。